Не сболтнуть лишнего: правила осторожности при общении с нейросетями

Искусственный интеллект находит применение не только в повседневной жизни, но и в бизнесе. Тем не менее, как и другие технологии, работающие с большими данными, он может представлять определенные риски. Прежде всего, это касается безопасности информации. Мы разберемся, на что нужно обращать внимание при взаимодействии с нейросетями, чтобы избежать утечек: делится Дмитрий Крюков, руководитель отдела машинного обучения «МТС Линк».

Конфиденциальные данные: что это такое

Для начала определим, что такое конфиденциальная информация. Это данные, разглашение которых может повредить физическим и юридическим лицам. К ним относятся:

персональные (паспортные данные, СНИЛС, медицинская информация, данные о доходах), а также контактные данные, такие как номер телефона и адрес электронной почты;корпоративные (внутренние процессы, аналитика, информация о клиентах и сотрудниках, юридические риски);коммерческие тайны (технологические секреты, стратегические активы, рыночные инсайты и финансовая отчетность);государственные (классифицированные) — о них мы поговорим позже.

Защита этих данных регулируется законодательством.

В современном обществе большинство людей осознают важность защиты личной информации и последствия утечек. Корпорации в свою очередь разрабатывают системы для обеспечения безопасности данных. В связи с этим возникает вопрос: как конфиденциальные данные могут оказаться в руках искусственного интеллекта?

Пути попадания личной информации к нейросетям

Прежде всего, речь идет об общедоступных ИИ-моделях, таких как ChatGPT (OpenAI), Claude (Anthropic), DeepSeek, Midjourney, Gemini (Google), Copilot (Microsoft) и других.

Эти системы обучаются на больших объемах данных, включая открытые источники: сайты, социальные сети, статьи и документы, изображения и видео с доступных платформ. Кроме того, разработчики могут приобретать лицензированные наборы данных. Специальные модели могут обучаться в определенных областях, таких как медицина или юриспруденция. Персональные данные могут случайно оказаться в обучающих наборах, даже если они были анонимизированы, так как ИИ может восстановить личность на основе анализа параметров.

Еще один способ — когда пользователи сами вводят свои данные, взаимодействуя с открытыми ИИ-сервисами:

например, загружают документы для анализа, отправляют резюме или проверяют грамотность;задают вопросы и просят составить отчеты на основе конкретных данных;озвучивают свои имена, телефоны и адреса голосовым помощникам, таким как «Алиса» от «Яндекса» или «Маруся» от Mail.ru;передают номера своих банковских карт цифровым помощникам;вносят личные данные в медицинских чат-ботах (например, от Cleverbots);передают данные через переводческие сервисы;предоставляют доступ к личным и корпоративным почтовым ящикам при подключении соответствующих услуг.

Популярные облачные сервисы, такие как «Яндекс Диск», «Google Диск» и OneDrive, также используют алгоритмы ИИ. Они применяют технологии оптического распознавания текста и изображений (OCR) для поиска документов и файлов. В этих сервисах хранится огромное количество личной и корпоративной информации, что дает им доступ к этим данным.

Как делиться данными с осторожностью

Важно отметить, что обмен данными с ИИ не всегда представляет угрозу безопасности. Нейросети завоевывают популярность благодаря своим уникальным возможностям, и отказываться от их использования не стоит.

Они способны обрабатывать большие объемы данных, автоматизировать множество процессов, быстро генерировать текст и визуальный контент, преодолевать языковые барьеры и минимизировать человеческие ошибки. При этом они постоянно обучаются, чтобы предоставлять людям более качественные решения.

Наиболее популярные ИИ-сервисы доступны бесплатно. Однако их разработчики получают прибыль менее очевидными способами:

например, используя данные для дальнейшего обучения (с анонимизацией), что само по себе имеет ценность;продавая агрегированные данные третьим лицам для таргетированной рекламы (обычно это делают небольшие стартапы);предлагая платные подписки на расширенные функции, когда базовый функционал доступен всем, а для дополнительных возможностей требуется оплата;лицензируя свои технологии, позволяя интегрировать нейросети в другие приложения;используя краудфандинг, фандрайзинг и финансирование от инвесторов.

Важно помнить, что нейросети, обученные на открытых данных, не умеют различать конфиденциальную и публичную информацию — это задача пользователей. Хотя крупные платформы, такие как OpenAI или Claude, стараются избегать передачи данных из-за репутационных рисков, безопасность информации в первую очередь зависит от самих пользователей.

Как определить безопасность нейросети

Многие открытые ИИ-модели функционируют через облачные сервисы, что позволяет масштабировать их использование. Информация хранится на серверах в центрах обработки данных (ЦОД). Таким образом, доступ к данным, отправляемым пользователями нейросетям (запросы, файлы), получают не только разработчики, но и облачные провайдеры. Кроме того, государственные органы могут получить доступ к этим данным по судебному решению. ЦОД могут находиться в разных странах, что подчиняет их различным юрисдикциям.

Обычно сервисы на базе ИИ, которые собирают данные о пользователях, запрашивают у них разрешение на обработку данных. Иногда пользователям нужно поставить галочку, а в других случаях сервис может сообщить, что, используя его, они автоматически соглашаются на обработку данных.

Чтобы отличить надежный ИИ-сервис от потенциально небезопасного, следует придерживаться нескольких рекомендаций:

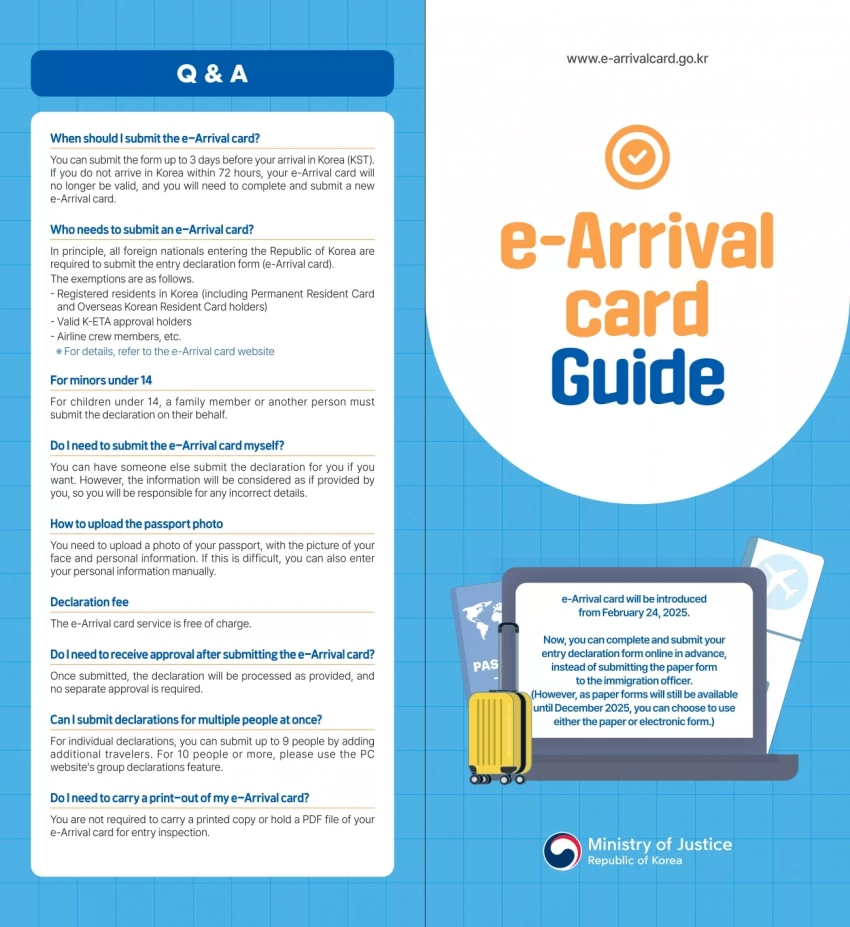

Изучите политику конфиденциальности — следует проверить, есть ли в ней пункты об использовании данных, включая дообучение, и возможность отмены этой опции. Например, в ChatGPT можно отключить историю и запоминание чатов. В китайских DeepSeek и Copilot корпоративные подписки позволяют отключить сбор данных. В Gemini и других системах данные часто используются для улучшения модели.

Пользовательский кабинет ChatGPT: согласие на обработку данных для дообучения. Источник: пресс-служба «МТС Линк»

Убедитесь, что ИИ-сервис анонимизирует данные. Обмен данными с источниками, которые применяют такую защиту, считается относительно безопасным. Однако проверить, действительно ли это происходит, часто невозможно. Следует с осторожностью относиться к менее известным аналогам популярных нейросетей, генераторам документов и резюме, а также программам для написания писем.

Узнайте, где находятся серверы и кому принадлежит нейросеть: США, ЕС, Китай? Уровень защиты может варьироваться в зависимости от региона. У небольших облачных провайдеров, как правило, меньше ресурсов и внимания к соблюдению правил, что приводит к меньшей прозрачности. Существуют и поставщики в странах с менее строгими регуляциями, например, в некоторых регионах Азии и Африки. Наличие международных сертификатов может указать на репутацию поставщика.

Проверьте отзывы о сервисе и случаи утечек — известны ли случаи утечки данных. Чаще всего это происходит из-за недобросовестных провайдеров или через незащищенные каналы. Однако даже проверенные ИИ-сервисы могут стать жертвами целевых кибератак.

Главные риски для пользователей нейросетей

Как и любая другая новая технология, нейросети, обрабатывающие миллионы запросов, становятся мишенью для злоумышленников. Международное аналитическое агентство в области финансов Bobsguide опубликовало данные отчета Cybercrime Trends 2025 (SoSafe), согласно которому 87% организаций сообщили об угрозах, связанных с ИИ. А 91% специалистов по кибербезопасности ожидают, что эти угрозы возрастут в ближайшие три года.

Фишинг, известный в традиционных сервисах, также касается сферы ИИ. Мошенники создают поддельные инструменты, имитирующие популярные нейросети (например, фейковый ChatGPT), используют генеративные ИИ для создания фальшивых писем, изображений или видео. Их цель — получить личные данные пользователей для кражи или шантажа, включая компании.

Чтобы не стать жертвой мошенников, проверяйте доменные имена, электронные адреса и телефоны отправителей, а также будьте внимательны к ссылкам и запросам на подтверждение.

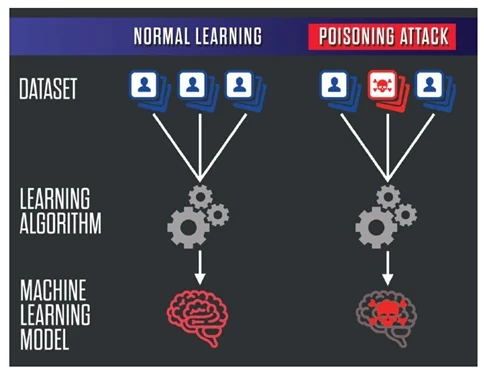

Существует также угроза, связанная с машинным обучением — это «отравление данных» (data poisoning). Это процесс, при котором вредоносные данные вводятся в обучающие наборы ИИ-моделей, что может искажать результаты и приводить к проблемам с безопасностью, например, при распознавании лиц, искажении диагнозов и медицинских назначений.

Для защиты от «отравления» помимо традиционных методов (антивирус, брандмауэр, контроль сетей) необходимо проводить аудит наборов данных, отслеживать аномалии и настраивать валидацию данных.

Схема, иллюстрирующая процесс отравления данных при обучении нейросетей. Источник

Недостоверность информации — это нежелательное, но возможное свойство самих нейросетей. Несмотря на широкий функционал, ИИ может допускать ошибки. Например, он может приводить несуществующие данные или воспринимать неоднозначные сведения как достоверные.

При работе с ИИ полезно следовать принципу «доверяй, но проверяй»: можно задать вопрос о том, откуда ИИ взял данные и насколько он уверен в своей правоте. Проверенные модели готовы признать ошибки и предоставить пояснения. Однако наилучший подход — это использование экспертного контроля для проверки решений ИИ, особенно в случае важно документов и отчетов.

В 2023 году Samsung столкнулся с утечкой данных из-за сотрудников, случайно загрузивших внутренний код в ChatGPT. В результате компания запретила использование генеративного ИИ на своих устройствах и ввод данных, касающихся Samsung, в ChatGPT.

В том же году OpenAI также сообщила об утечке данных пользователей ChatGPT. Из-за ошибки в библиотеке с открытым исходным кодом некоторые пользователи могли видеть чужие сообщения и личные данные других пользователей. Система была отключена на несколько часов, и проблема была устранена, но этот инцидент вызвал обеспокоенность среди пользователей.

Безопасное взаимодействие с ИИ в бизнесе

Хотя в повседневной жизни риски взаимодействия с нейросетями можно уменьшить с помощью внимательности, в бизнесе ситуация выглядит иначе.

В данной сфере, помимо личных данных, в обращении находятся коммерческие тайны, патенты, стратегии и технические детали. Утечки данных и вмешательства могут нанести компаниям огромный финансовый и репутационный ущерб. Публичные облачные нейросети требуют особого внимания к безопасности даже при интеграции через API, и оправданность таких рисков может быть сомнительной.

Тем не менее, полностью отказываться от использования ИИ в бизнесе нецелесообразно. На помощь приходят корпоративные облачные нейросети. Они не только упрощают процессы, но и обеспечивают более высокий уровень безопасности для компаний.

Эти сервисы предлагают повышенные меры безопасности и расширенные настройки:

В корпоративных решениях компании контролируют обработку данных, а в открытых облачных сервисах данные могут передаваться сторонним провайдерам. В корпоративном формате можно ограничить доступ, установить политику хранения и удаления информации, а также настроить сертификацию для работы с конфиденциальными данными, чего нет в общедоступных сервисах. Открытые алгоритмы более уязвимы к атакам, в то время как корпоративные решения обеспечивают большую защиту.

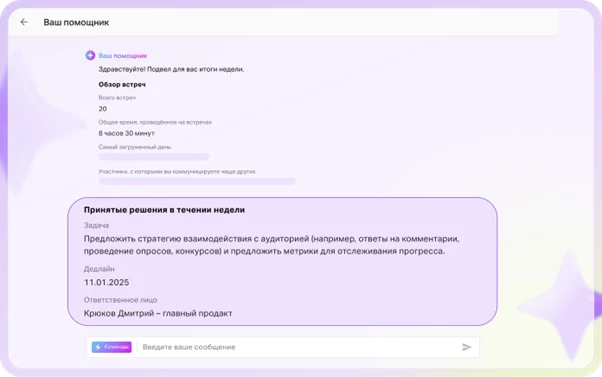

Корпоративные облачные нейросети могут служить основой для продуктов (как, например, NTechLab в России, которая обеспечивает распознавание лиц и работает с городской сетью камер Москвы) или дополнительно улучшать существующие. Например, в системе Directum RX, используемой для управления данными, встроенный ИИ помогает генерировать документы, письма, анализировать контент и распределять задачи, выявлять трудозатратные процессы. В экосистеме «МТС Линк» ИИ помогает создавать резюме и расшифровки звонков, а также генерирует видеохайлайты — короткие видео с основными моментами онлайн-встреч. В этой платформе также интегрирован виртуальный ассистент.

Виртуальный ассистент «МТС Линк». Источник — пресс-служба «МТС Линк»

Альтернативой корпоративным облачным нейросетям может стать развертывание self-hosted-моделей — наилучший вариант по уровню безопасности. Это подразумевает создание собственных ИИ-систем на оборудовании компании. Все серверы, функционал и наборы данных разрабатываются внутри организации или на локальных устройствах, без передачи данных третьим лицам. Хотя такой подход очень надежен (даже если хакеры могут проявить интерес к таким системам), он требует значительных вложений на создание и поддержку инфраструктуры.

В общем, ИИ-сервисы для бизнеса помогают значительно улучшить рабочие процессы и рутинные операции. Они могут охватывать многие сферы, включая взаимодействие с клиентами, онлайн-встречи для большого числа сотрудников, маркетинговые решения и многое другое. Например, MTS AI разрабатывает проекты в области видеоаналитики, синтеза речи и умного прогнозирования.

Обсудим?

Смотрите также: